La aplicación adquiere datos de movimiento avanzados por sólo el 1% del coste normal

OpenCap

Utilizando vídeo sincronizado capturado con un par de teléfonos inteligentes, los científicos han desarrollado una aplicación de captura de movimiento de código abierto. Esta aplicación recopila datos sobre los movimientos humanos y emplea inteligencia artificial para su rápido análisis, lo que la hace idónea para aplicaciones clínicas como la rehabilitación, la planificación preoperatoria y el diagnóstico de enfermedades. Y, lo que es más sorprendente, lo consigue por apenas un 1% del coste de la tecnología convencional.

Sin embargo, investigadores de la Universidad de Stanford, con financiación de los Institutos Nacionales de Salud de EE.UU., presentaron OpenCap. Este innovador sistema se basa en dos iPhones calibrados con precisión que trabajan en tándem para medir el movimiento humano y los intrincados procesos musculoesqueléticos que subyacen al movimiento.

Además, supera a las tecnologías tradicionales en velocidad de recopilación de datos y representa una pequeña fracción del gasto en que incurren las clínicas especializadas que utilizan elaborados montajes de aproximadamente 150.000 dólares, que suelen implicar unas ocho cámaras avanzadas.

Inclusión del análisis del movimiento humano con OpenCap

Scott Delp, autor principal y profesor de bioingeniería e ingeniería mecánica en Stanford, afirma: “OpenCap pone el análisis del movimiento humano al alcance de todos. Nuestra aspiración es poner a disposición de un público más amplio estas herramientas antes inaccesibles”.

Sin embargo, los datos obtenidos de este análisis pueden ofrecer ideas para el tratamiento de personas con problemas relacionados con el movimiento, ayudar a los profesionales sanitarios en la planificación quirúrgica y evaluar la eficacia de distintas terapias. Además, tiene potencial para utilizarse en la detección de enfermedades, sobre todo en los casos en que las alteraciones de la marcha o el equilibrio no se aprecien fácilmente en los reconocimientos médicos rutinarios.

Uhlrich, S et al/(CC BY 4.0)

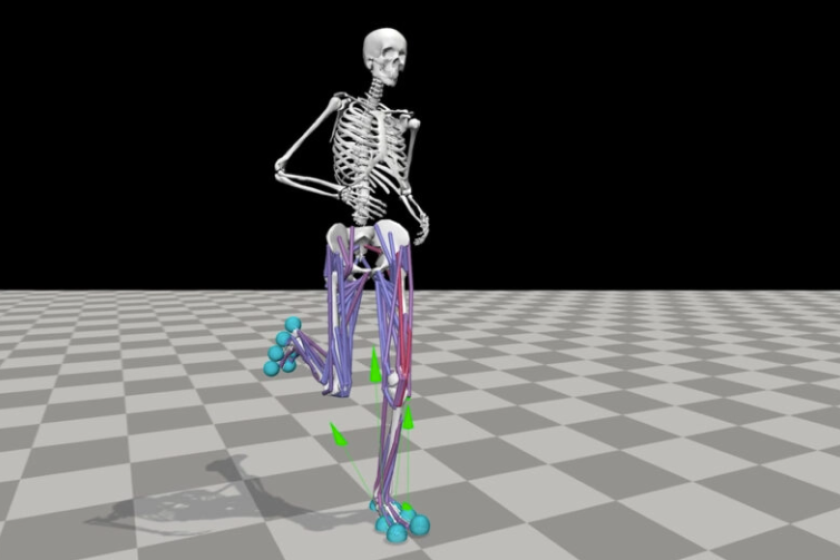

Realizaron pruebas utilizando OpenCap con 100 participantes, capturando vídeos que posteriormente fueron analizados por inteligencia artificial basada en la web para evaluar la activación muscular, la carga articular y el movimiento de las articulaciones.

El proceso completo de recopilación de datos para los 100 participantes se completó en menos de 10 horas, y los resultados del análisis se devolvieron en 31 horas. La recogida de datos de cada individuo llevó aproximadamente 10 minutos, y el procesamiento se inició automáticamente dentro de la plataforma en la nube de libre acceso para los investigadores.

Scott Uhlrich, co-primer autor y director de investigación del Laboratorio de Rendimiento Humano de Stanford, comentó: “Lo que OpenCap consigue en minutos le llevaría días a un ingeniero cualificado recopilar y analizar en términos de datos biomecánicos. Conseguimos recopilar datos de 100 individuos en menos de 10 horas, una tarea que antes nos habría llevado un año completar.”

Exploración de puntos de referencia y fuerzas corporales con OpenCap

Los datos examinan puntos anatómicos cruciales del cuerpo, como las rodillas, las caderas, los hombros y otras articulaciones, observando su movimiento dentro de un espacio tridimensional. A continuación, utiliza intrincados modelos basados en los principios de la física y la biología relacionados con el sistema musculoesquelético para evaluar el movimiento del cuerpo y las fuerzas implicadas. Este análisis proporciona información significativa sobre los ángulos de las articulaciones y las fuerzas ejercidas sobre ellas.

Como explicó Delp, este sistema puede incluso identificar los músculos concretos que intervienen en el proceso.

De hecho, los investigadores prevén que este tipo de recopilación de datos, combinada con el análisis de aprendizaje profundo, representa un avance revolucionario en la investigación biomecánica.

El “genoma del movimiento” cuantitativo del movimiento humano

Delp comentó: “Tenemos el genoma humano, pero esto va a ser esencialmente el ‘movimiento-genoma’ completo del movimiento humano, capturado de forma cuantitativa”.

Sin embargo, añadió: “Nuestra aspiración es que, al hacer más accesible el análisis del movimiento humano a través de OpenCap, se agilice la integración de métricas biomecánicas vitales en un número cada vez mayor de estudios de investigación, ensayos clínicos y prácticas médicas, mejorando en última instancia los resultados para los pacientes de todo el mundo.”

De hecho, el estudio se ha publicado en PLOS Computational Biology. Para más detalles, puedes ver el siguiente vídeo, en el que el equipo de Stanford demuestra las capacidades de OpenCap.

imagen/vídeo

Read the original article on: New Atlas

Read more: Millisign Tech Guides Drones with Battery-Less Ground Tags